Para estudiar a las ballenas que pueblan los océanos los científicos utilizan diversas técnicas, entre ellas la observación directa, las imágenes de satélite y los hidrófonos (micrófonos submarinos), con los que graban sus curiosas e hipnotizantes «canciones». Y desde hace algún tiempo un equipo de oceanógrafos ha estado trabajando junto con Google en la utilización de tecnología propia de la inteligencia artificial para ubicar con mayor precisión y rapidez a estos fascinantes mamíferos marinos.

En concreto en la zona en la que opera el Centro de Investigación de Cetáceos de las Islas del Pacífico estadounidense, con sede en Hawaii, hay datos desde hace una década de grabaciones de hidrófonos situados en 13 ubicaciones distintas, totalizando 170.000 horas de grabaciones y más de 200 terabytes de datos. Información sumamente interesante para realizar los seguimientos de estas especies… pero tan voluminosos que no se pueden procesar simplemente «oyéndolos con paciencia», como se venía haciendo tradicionalmente.

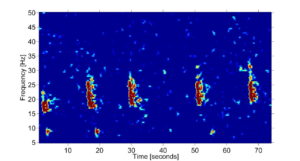

Buscando un poco de ayuda, el centro contactó con Google hace tiempo, en concreto del grupo de interpretación de datos de la percepción que analiza datos como la voz, imágenes y las constantes vitales en temas de salud. Los oceanógrafos les proporcionaron un pequeño conjunto de datos de audio (unos 9 TB) de los que se aislaron ciertas frecuencias correspondientes a los de la «vocalización» de las ballenas jorobadas: de 100 a 2.000 Hz. La idea era ver si sería posible entrenar a una máquina para entender las peculiares «canciones» de las ballenas, separando esos sonidos de otros ruidos del ambiente marino.

Para ello utilizaron la técnica de aprendizaje supervisado que usan muchos proyectos de inteligencia artificial. En primer lugar una persona experta marca todos los ejemplos que encuentra diferenciando lo que son cánticos de ballena respecto a otros sonidos (barcos, ruidos) junto con la duración aproximada, que suele estar en torno a 20 minutos. Poco a poco, el algoritmo va aprendiendo a distinguir unos sonidos de otros, a hacer «predicciones» sobre lo que analiza y verlas confirmadas o no. El resultado es que tras un periodo de entrenamiento puede identificar en clips de corta duración las canciones de las ballenas con un 90% de precisión. En el futuro creen que podría usarse la misma técnica para otras especies, como los delfines, y también para detectar embarcaciones por el sonido de sus hélices.

Para ello utilizaron la técnica de aprendizaje supervisado que usan muchos proyectos de inteligencia artificial. En primer lugar una persona experta marca todos los ejemplos que encuentra diferenciando lo que son cánticos de ballena respecto a otros sonidos (barcos, ruidos) junto con la duración aproximada, que suele estar en torno a 20 minutos. Poco a poco, el algoritmo va aprendiendo a distinguir unos sonidos de otros, a hacer «predicciones» sobre lo que analiza y verlas confirmadas o no. El resultado es que tras un periodo de entrenamiento puede identificar en clips de corta duración las canciones de las ballenas con un 90% de precisión. En el futuro creen que podría usarse la misma técnica para otras especies, como los delfines, y también para detectar embarcaciones por el sonido de sus hélices.

Lo interesante de esta aplicación de la IA de Google es que resulta una aplicación un tanto «inesperada»: no era algo para lo que se hubiera creado originalmente, sino que se ha podido adaptar estableciendo algunos filtros para fijarse en esos «sonidos no humanos». A medida que se graba más información y se puede procesar ágilmente mediante los equipos de computación en la nube, los oceanógrafos pueden saber en menos tiempo dónde están los grupos de ballenas en cada momento de las temporadas, hacia donde se producen las migraciones, cuál es su número y su distribución, ampliando así sus conocimientos gracias a una ayuda automática que resulta bastante eficiente.

Foto | (CC) M. Cheng @ GoodFreePhotos