La investigación de los sistemas de conducción autónoma al igual que los de visión artificial se enfrentan a un particular problema: se necesitan muchos datos en bruto con los que entrenar y probar los algoritmos que se desarrollan. En particular, en el caso de los vehículos que conducen ayudados por cámaras y LiDAR se necesitan vídeos –literalmente, miles de horas de vídeos– para asegurarse de que los sistemas autónomos son capaces de reconocer las carreteras, carriles, señales de tráfico, vehículos y naturalmente los semáforos, peatones, ciclistas y otros objetos que puedan aparecer en las diversas «escenas».

Aunque usando vehículos propios los investigadores amasan miles de horas de vídeo con los que trabajar, es complicado obtener material más genérico y en todas las condiciones posibles. Por suerte, algunos de los laboratorios que investigan estos temas comparten públicamente sus datos. Este es el caso de la iniciativa Berkeley Deep Drive, donde los investigadores de la Universidad de Berkeley (Estados Unidos) recopilan, clasifican y ponen a disposición de cualquiera ingentes cantidades de información para que quien esté interesado por el tema pueda crear y mejorar nuevos sistemas de conducción autónoma –algo que viene estupendamente tanto a la industria automovilística en general como a quienes desarrollan hardware y software en este terreno en particular.

Aunque usando vehículos propios los investigadores amasan miles de horas de vídeo con los que trabajar, es complicado obtener material más genérico y en todas las condiciones posibles. Por suerte, algunos de los laboratorios que investigan estos temas comparten públicamente sus datos. Este es el caso de la iniciativa Berkeley Deep Drive, donde los investigadores de la Universidad de Berkeley (Estados Unidos) recopilan, clasifican y ponen a disposición de cualquiera ingentes cantidades de información para que quien esté interesado por el tema pueda crear y mejorar nuevos sistemas de conducción autónoma –algo que viene estupendamente tanto a la industria automovilística en general como a quienes desarrollan hardware y software en este terreno en particular.

Su más reciente aportación es la llamada BDD100K, que como su nombre indica incluye 100.000 vídeos grabados por vehículos autónomos, clasificados y anotados –unas 1.100 horas de conducción en total. Esta base de datos es casi mil veces más grande que otras similares que se han compartido en el pasado con el mismo propósito.

Cada vídeo tiene una duración de unos 40 segundos y está grabado a una resolución HD de 720 líneas a 30 fotogramas por segundo. Además de las imágenes, cada vídeo va acompañado de metadatos: información adicional que permite afinar mejor las investigaciones. Por ejemplo, cada vídeo va marcado con las posiciones GPS (coordenadas geográficas) e IMU (velocidad y orientación; procedentes de una Unidad de Medición Inercial) del vehículo. Para garantizar la variedad se han incluido diferentes ciudades y tipos de calles y carreteras, así como toda una variedad de condiciones meteorológicas: lluvia, nieve, sol, niebla… Esta base de datos es de Estados Unidos, pero iniciativas similares en Europa y en cada país permitirían «afinar» aún más la calidad y autonomía de la conducción de estos vehículos.

Cada vídeo tiene una duración de unos 40 segundos y está grabado a una resolución HD de 720 líneas a 30 fotogramas por segundo. Además de las imágenes, cada vídeo va acompañado de metadatos: información adicional que permite afinar mejor las investigaciones. Por ejemplo, cada vídeo va marcado con las posiciones GPS (coordenadas geográficas) e IMU (velocidad y orientación; procedentes de una Unidad de Medición Inercial) del vehículo. Para garantizar la variedad se han incluido diferentes ciudades y tipos de calles y carreteras, así como toda una variedad de condiciones meteorológicas: lluvia, nieve, sol, niebla… Esta base de datos es de Estados Unidos, pero iniciativas similares en Europa y en cada país permitirían «afinar» aún más la calidad y autonomía de la conducción de estos vehículos.

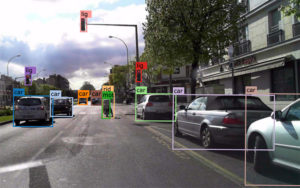

Además de el vídeo y esos metadatos en los vídeos de la BDD100K, también hay «anotaciones» procedentes de un sistema desarrollado por la propia universidad que indican cada pocos fotogramas qué se ve exactamente en el vídeo: objetos (semáforos, coches, ciclistas, camiones), líneas de las carreteras, «cajas» (que ocupan el espacio de los vehículos), pasos de cebra… Como realizar estas anotaciones es bastante complicado, el sistema combina las procedentes de varios algoritmos bien conocidos por los expertos. De este modo, se pueden analizar los vídeos y sus anotaciones para compararlos con la efectividad de nuevos sistemas que se estén desarrollando (los interesados pueden consultar el trabajo completo: BDD100K: A Diverse Driving Video Database with Scalable Annotation Tooling).

Además de el vídeo y esos metadatos en los vídeos de la BDD100K, también hay «anotaciones» procedentes de un sistema desarrollado por la propia universidad que indican cada pocos fotogramas qué se ve exactamente en el vídeo: objetos (semáforos, coches, ciclistas, camiones), líneas de las carreteras, «cajas» (que ocupan el espacio de los vehículos), pasos de cebra… Como realizar estas anotaciones es bastante complicado, el sistema combina las procedentes de varios algoritmos bien conocidos por los expertos. De este modo, se pueden analizar los vídeos y sus anotaciones para compararlos con la efectividad de nuevos sistemas que se estén desarrollando (los interesados pueden consultar el trabajo completo: BDD100K: A Diverse Driving Video Database with Scalable Annotation Tooling).

Este tipo de iniciativas permiten mejorar las posibilidades de investigación para todas las organizaciones, los expertos y las empresas involucradas, muy en el espíritu abierto y público de la ciencia y muchas áreas de la tecnología. En algún sitio puede que haya alguien capaz de desarrollar algoritmos estupendos, pero sin medios o capacidad para grabar miles de horas de vídeo real, algo que con estas aportaciones iguala las posibilidades en pos del bien común.