Los avances en inteligencia artificial (IA) van llegando poco a poco a diferentes áreas de la tecnología, desde cuestiones tan cotidianas como «hablar a Siri» a sistemas de reconocimiento visual que permiten predecir qué está haciendo una persona cuando camina o incluso qué objetos se ven frente a un vehículo cuando circula por calles y carreteras. Sin embargo, no todo lo que parece IA lo es y de hecho hay muchos tecnólogos que consideran que es un término de moda del que se abusa cuando se habla de otras tecnologías que parecen comportarse de forma inteligente, pero en realidad no son más que cálculos estadísticos u otro tipo de casi de «trucos».

En Fast Company publicaron un artículo acerca de Los diez momentos más importantes en la historia de la IA hasta ahora, donde se enumeran desde el enunciado de las novelescas Leyes de la robótica de Isaac Asimov al famoso Test de Turing que el pionero de la informática concibió para diferenciar a humanos de máquinas. Sin embargo, no todos los hitos mencionados en el artículo son avances tan claros.

Un ejemplo claro es el encuentro de ajedrez entre Deep Blue y Gary Kasparov en 1997, que tuvo un gran eco, especialmente mediático. Los expertos coinciden en que la máquina ganó «por fuerza bruta» y que no había mucha inteligencia en su comportamiento, aunque sí capacidad de cálculo, que Kasparov infravaloró. Tampoco hay mucha gente que defienda hoy en día la equivalencia directa inteligencia = ajedrez, pues es un dominio muy constreñido y de poca utilidad genérica.

Un ejemplo claro es el encuentro de ajedrez entre Deep Blue y Gary Kasparov en 1997, que tuvo un gran eco, especialmente mediático. Los expertos coinciden en que la máquina ganó «por fuerza bruta» y que no había mucha inteligencia en su comportamiento, aunque sí capacidad de cálculo, que Kasparov infravaloró. Tampoco hay mucha gente que defienda hoy en día la equivalencia directa inteligencia = ajedrez, pues es un dominio muy constreñido y de poca utilidad genérica.

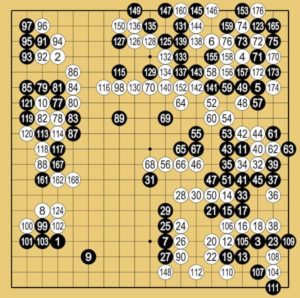

Sin embargo, la victoria de AlphaGo de Google frente al campeón mundial de Go, Lee Sidol en 2016, sí que se considera dentro del terreno de la IA, por el uso del aprendizaje automático y el aprendizaje por refuerzo (dos técnicas habituales) para mejorar su nivel. De hecho es todavía más increíble que AlphaZero lograra al año siguiente un nivel sobrehumano tanto en Go, como en Shogi y Ajedrez tras un brevísimo «autoaprendizaje»: en 4 horas fue superior a cualquier humano o máquina al ajedrez a partir únicamente de la reglas y el autoaprendizaje, sin siquiera conocer lo que eran las aperturas o los finales.

Respecto a las leyes de la robótica, parece claro que no es algo que los robots actuales vayan a implementar: simplemente no funcionan. Fueron concebidas para crear situaciones comprometidas y novelescas, no con un objetivo real. Más importantes serán quizás las leyes y normas que se dicten respecto al uso de la IA en el futuro. Incluso el propio test de Turing (una máquina se consideraría inteligente si no podemos distinguirla de un ser humano en una conversación a través de un teclado) ha debido ser matizado y es cada día más cuestionado, aunque casi más por el lado filosófico que el puramente técnico. El hecho es que hace tiempo estamos viendo a las máquinas hacer cosas que parecen inteligentes, aunque sabemos que lo hacen máquinas detrás de las que hay algoritmos. Y quizá por eso nos parecen «no tan inteligentes».

Entre otros momentos relevantes se mencionan también el concepto del perceptrón de Frank Rosenblatt en 1957 o los inviernos tecnológicos de las décadas de los 60 y 90 en los que el desarrollo de la IA pareció estancado. Por suerte, lo que no podía resolverse de una forma se resolvió de otra, la potencia y coste del hardware hizo posibles cálculos que se consideraban impracticables y surgieron nuevas ideas. La gente empezó a ver cómo actividades que parecían casi imposibles como librarse del correo basura en el email, o traducir textos, se volvía «mágicamente inteligente» en las décadas de los 2000 y 2010. Pero tanto los filtros antispam de Gmail, como el Traductor de Google, eran también «trucos algorítmicos»: estadísticas avanzadas que comparaban textos en muchos idiomas para elegir la traducción más probable, o largas series de chequeos contra reglas y filtros variados que había que actualizar. Fueron todo un ejemplo de ingenio, y de hecho son muy prácticos, pero no se consideran inteligencia artificial como tal. Hoy hay sistemas traductores mejores, como DeepL, que emplean aprendizaje automático –junto también con corpus masivos de originales en diversos idiomas– para lograr traducciones aún mejores.

Quizá el hito menos conocido popularmente de la lista pero más relevante fuera la victoria en 2012 de la red neuronal AlexNet de Geoffrey Hinton en el concurso de ImageNet, en el que los desarrolladores competían para ver quién creaba el mejor software de reconocimiento visual de imágenes. Distinguir gatos de perros o rostros de personas resultó más fácil de lo que parecía con esos sistemas. El comportamiento de aquella red neuronal fue espectacular y mostró el camino que han seguido los sistemas de IA mediante redes neuronales que se utilizan hoy en día en cámaras de fotos, vehículos e incluso los sistemas de asistencia a la conducción.